규칙을 작성할 때 가장 일반적인 성능 문제는 종속 항목에서 누적된 데이터를 탐색하거나 복사하는 것입니다. 전체 빌드에 걸쳐 집계하면 이러한 작업은 쉽게 O(N^2) 시간 또는 공간을 사용할 수 있습니다. 이를 방지하려면 depset을 효과적으로 사용하는 방법을 이해하는 것이 중요합니다.

이를 올바르게 수행하기가 어려울 수 있으므로 Bazel은 실수가 있을 수 있는 위치를 찾는 데 도움이 되는 메모리 프로파일러도 제공합니다. 주의: 비효율적인 규칙을 작성하는 데 드는 비용은 광범위하게 사용될 때까지 분명하지 않을 수 있습니다.

depset 사용

규칙 종속 항목의 정보를 롤업할 때마다 depsets를 사용해야 합니다. 일반 목록이나 사전을 사용하여 현재 규칙에 관한 로컬 정보를 게시하는 경우에만 사용하세요.

depset은 공유를 지원하는 중첩 그래프로 정보를 나타냅니다.

다음 그래프를 살펴보세요.

C -> B -> A

D ---^

각 노드는 단일 문자열을 게시합니다. depset을 사용하면 데이터가 다음과 같이 표시됩니다.

a = depset(direct=['a'])

b = depset(direct=['b'], transitive=[a])

c = depset(direct=['c'], transitive=[b])

d = depset(direct=['d'], transitive=[b])

각 항목은 한 번만 언급됩니다. 목록을 사용하면 다음과 같은 이점이 있습니다.

a = ['a']

b = ['b', 'a']

c = ['c', 'b', 'a']

d = ['d', 'b', 'a']

이 경우 'a'가 4번 언급됩니다. 그래프가 클수록 이 문제는 더욱 심각해집니다.

다음은 depset을 올바르게 사용하여 전이 정보를 게시하는 규칙 구현의 예입니다. 원하는 경우 목록을 사용하여 규칙 로컬 정보를 게시해도 됩니다. O(N^2)가 아니기 때문입니다.

MyProvider = provider()

def _impl(ctx):

my_things = ctx.attr.things

all_things = depset(

direct=my_things,

transitive=[dep[MyProvider].all_things for dep in ctx.attr.deps]

)

...

return [MyProvider(

my_things=my_things, # OK, a flat list of rule-local things only

all_things=all_things, # OK, a depset containing dependencies

)]

자세한 내용은 depset 개요 페이지를 참고하세요.

depset.to_list() 호출 피하기

to_list()를 사용하여 depset을 평면 목록으로 강제 변환할 수 있지만 이렇게 하면 일반적으로 O(N^2) 비용이 발생합니다. 디버깅 목적을 제외하고는 가능한 한 depset을 평탄화하지 마세요.

<xx>_binary 규칙과 같은 최상위 타겟에서만 의존 항목 집합을 평탄화하면 비용이 빌드 그래프의 각 수준에 누적되지 않으므로 자유롭게 평탄화할 수 있다는 일반적인 오해가 있습니다. 하지만 중복 종속 항목이 있는 타겟 세트를 빌드할 때는 여전히 O(N^2)입니다. 이는 테스트 //foo/tests/...를 빌드할 때 또는 IDE 프로젝트를 가져올 때 발생합니다.

depset 호출 횟수 줄이기

루프 내에서 depset를 호출하는 것은 실수인 경우가 많습니다. 이로 인해 성능이 저하되는 매우 깊은 중첩이 있는 depset이 생성될 수 있습니다. 예를 들면 다음과 같습니다.

x = depset()

for i in inputs:

# Do not do that.

x = depset(transitive = [x, i.deps])

이 코드는 쉽게 교체할 수 있습니다. 먼저 전이 종속 항목 집합을 수집하고 모두 한 번에 병합합니다.

transitive = []

for i in inputs:

transitive.append(i.deps)

x = depset(transitive = transitive)

목록 이해를 사용하여 줄일 수 있는 경우도 있습니다.

x = depset(transitive = [i.deps for i in inputs])

명령줄에 ctx.actions.args() 사용

명령줄을 빌드할 때는 ctx.actions.args()를 사용해야 합니다. 이렇게 하면 모든 depset의 확장이 실행 단계로 지연됩니다.

이렇게 하면 속도가 훨씬 빨라질 뿐만 아니라 규칙의 메모리 사용량이 줄어들 수 있습니다(최대 90% 이상).

다음은 몇 가지 방법입니다.

직접 평탄화하는 대신 depset 및 목록을 인수로 직접 전달합니다.

ctx.actions.args()만큼 자동으로 확장됩니다. depset 콘텐츠에 변환이 필요한 경우 ctx.actions.args#add를 살펴보고 적합한 항목이 있는지 확인하세요.File#path를 인수로 전달하고 있나요? 필요하지 않습니다. 모든 파일은 자동으로 경로로 변환되며 확장 시까지 지연됩니다.문자열을 연결하여 문자열을 구성하지 마세요. 가장 적합한 문자열 인수는 상수입니다. 메모리가 규칙의 모든 인스턴스 간에 공유되기 때문입니다.

args가 명령줄에 너무 긴 경우

ctx.actions.args()객체를ctx.actions.args#use_param_file를 사용하여 조건부 또는 무조건적으로 param 파일에 쓸 수 있습니다. 이는 작업이 실행될 때 백그라운드에서 실행됩니다. params 파일을 명시적으로 제어해야 하는 경우ctx.actions.write를 사용하여 수동으로 작성할 수 있습니다.

예:

def _impl(ctx):

...

args = ctx.actions.args()

file = ctx.declare_file(...)

files = depset(...)

# Bad, constructs a full string "--foo=<file path>" for each rule instance

args.add("--foo=" + file.path)

# Good, shares "--foo" among all rule instances, and defers file.path to later

# It will however pass ["--foo", <file path>] to the action command line,

# instead of ["--foo=<file_path>"]

args.add("--foo", file)

# Use format if you prefer ["--foo=<file path>"] to ["--foo", <file path>]

args.add(format="--foo=%s", value=file)

# Bad, makes a giant string of a whole depset

args.add(" ".join(["-I%s" % file.short_path for file in files])

# Good, only stores a reference to the depset

args.add_all(files, format_each="-I%s", map_each=_to_short_path)

# Function passed to map_each above

def _to_short_path(f):

return f.short_path

전이 작업 입력은 depset이어야 합니다.

ctx.actions.run을 사용하여 작업을 빌드할 때 inputs 필드가 depset을 허용한다는 점에 유의하세요. 입력이 종속 항목에서 전이적으로 수집될 때마다 사용하세요.

inputs = depset(...)

ctx.actions.run(

inputs = inputs, # Do *not* turn inputs into a list

...

)

걸이식

Bazel이 중단된 것처럼 보이면 Ctrl-\를 누르거나 Bazel에 SIGQUIT 신호 (kill -3 $(bazel info server_pid))를 전송하여 $(bazel info output_base)/server/jvm.out 파일에서 스레드 덤프를 가져올 수 있습니다.

bazel이 중단된 경우 bazel info를 실행할 수 없으므로 output_base 디렉터리는 일반적으로 작업공간 디렉터리의 bazel-<workspace> 심볼릭 링크의 상위 디렉터리입니다.

성능 프로파일링

Bazel은 기본적으로 출력 기반의 command.profile.gz에 JSON 프로필을 씁니다. --profile 플래그(예: --profile=/tmp/profile.gz)를 사용하여 위치를 구성할 수 있습니다. .gz로 끝나는 위치는 GZIP으로 압축됩니다.

결과를 보려면 Chrome 브라우저 탭에서 chrome://tracing를 열고 '로드'를 클릭한 다음 (압축되었을 수 있는) 프로필 파일을 선택합니다. 자세한 결과를 보려면 왼쪽 하단의 체크박스를 클릭하세요.

다음 키보드 컨트롤을 사용하여 탐색할 수 있습니다.

1키를 눌러 '선택' 모드를 선택합니다. 이 모드에서는 특정 상자를 선택하여 이벤트 세부정보를 검사할 수 있습니다 (왼쪽 하단 참고). 여러 이벤트를 선택하여 요약 및 집계된 통계를 확인합니다.2키를 눌러 '화면 이동' 모드를 선택합니다. 그런 다음 마우스를 드래그하여 뷰를 이동합니다.a/d를 사용하여 왼쪽/오른쪽으로 이동할 수도 있습니다.3키를 눌러 '확대/축소' 모드를 선택합니다. 그런 다음 마우스를 드래그하여 확대/축소합니다.w/s를 사용하여 확대/축소할 수도 있습니다.4를 눌러 두 이벤트 간의 거리를 측정할 수 있는 '타이밍' 모드를 사용합니다.?을(를) 눌러 모든 컨트롤에 대해 알아보세요.

프로필 정보

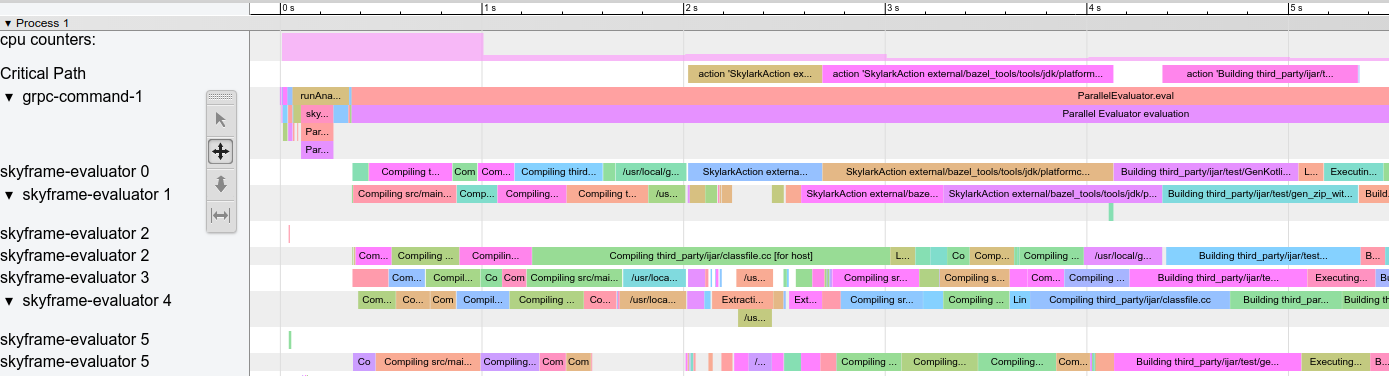

프로필 예시:

그림 1. 프로필 예시

몇 가지 특별한 행이 있습니다.

action counters: 진행 중인 동시 작업 수를 표시합니다. 클릭하여 실제 값을 확인합니다. 클린 빌드에서--jobs값까지 올라가야 합니다.cpu counters: 빌드의 초마다 Bazel에서 사용하는 CPU 양을 표시합니다 (값 1은 코어 1개가 100% 사용 중임을 나타냄).Critical Path: 중요 경로의 각 작업에 대해 하나의 블록을 표시합니다.grpc-command-1: Bazel의 기본 스레드입니다. Bazel이 실행하는 작업(예: 'Bazel 실행', 'evaluateTargetPatterns', 'runAnalysisPhase')을 대략적으로 파악하는 데 유용합니다.Service Thread: 경미한 가비지 컬렉션(GC) 일시중지와 심각한 가비지 컬렉션(GC) 일시중지를 표시합니다.

다른 행은 Bazel 스레드를 나타내며 해당 스레드의 모든 이벤트를 표시합니다.

일반적인 성능 문제

성능 프로필을 분석할 때는 다음을 확인하세요.

- 특히 증분 빌드에서 예상보다 느린 분석 단계 (

runAnalysisPhase) 이는 잘못된 규칙 구현의 신호일 수 있습니다(예: depset을 평탄화하는 규칙). 패키지 로드는 대상, 복잡한 매크로 또는 재귀식 글롭이 너무 많으면 느려질 수 있습니다. - 개별 느린 작업, 특히 핵심 경로에 있는 작업 대규모 작업을 여러 개의 작은 작업으로 분할하거나 (전이) 종속 항목 집합을 줄여 속도를 높일 수 있습니다. 또한 비정상적으로 높은

PROCESS_TIME외 항목 (예:REMOTE_SETUP또는FETCH)이 있는지 확인합니다. - 병목 현상: 소수의 스레드가 사용 중이면서 나머지 스레드는 유휴 상태이거나 결과를 기다리고 있습니다 (위 스크린샷에서 15~30초 참고). 이를 최적화하려면 규칙 구현 또는 Bazel 자체를 수정하여 병렬 처리를 더 많이 도입해야 할 가능성이 큽니다. 비정상적인 양의 GC가 발생할 때도 이 문제가 발생할 수 있습니다.

프로필 파일 형식

최상위 객체에는 메타데이터 (otherData)와 실제 추적 데이터(traceEvents)가 포함됩니다. 메타데이터에는 호출 ID, Bazel 호출 날짜와 같은 추가 정보가 포함됩니다.

예:

{

"otherData": {

"build_id": "101bff9a-7243-4c1a-8503-9dc6ae4c3b05",

"date": "Tue Jun 16 08:30:21 CEST 2020",

"profile_finish_ts": "1677666095162000",

"output_base": "/usr/local/google/_bazel_johndoe/573d4be77eaa72b91a3dfaa497bf8cd0"

},

"traceEvents": [

{"name":"thread_name","ph":"M","pid":1,"tid":0,"args":{"name":"Critical Path"}},

{"cat":"build phase marker","name":"Launch Bazel","ph":"X","ts":-1824000,"dur":1824000,"pid":1,"tid":60},

...

{"cat":"general information","name":"NoSpawnCacheModule.beforeCommand","ph":"X","ts":116461,"dur":419,"pid":1,"tid":60},

...

{"cat":"package creation","name":"src","ph":"X","ts":279844,"dur":15479,"pid":1,"tid":838},

...

{"name":"thread_name","ph":"M","pid":1,"tid":11,"args":{"name":"Service Thread"}},

{"cat":"gc notification","name":"minor GC","ph":"X","ts":334626,"dur":13000,"pid":1,"tid":11},

...

{"cat":"action processing","name":"Compiling third_party/grpc/src/core/lib/transport/status_conversion.cc","ph":"X","ts":12630845,"dur":136644,"pid":1,"tid":1546}

]

}

트레이스 이벤트의 타임스탬프 (ts) 및 기간 (dur)은 마이크로초로 표시됩니다. 카테고리 (cat)는 ProfilerTask의 열거형 값 중 하나입니다.

일부 이벤트는 길이가 매우 짧고 서로 가까우면 병합됩니다. 이벤트 병합을 방지하려면 --noslim_json_profile를 전달하세요.

Chrome Trace 이벤트 형식 사양도 참고하세요.

analyze-profile

이 프로파일링 방법은 두 단계로 구성됩니다. 먼저 --profile 플래그를 사용하여 빌드/테스트를 실행해야 합니다. 예를 들면 다음과 같습니다.

$ bazel build --profile=/tmp/prof //path/to:target

생성된 파일 (이 경우 /tmp/prof)은 바이너리 파일로, analyze-profile 명령어로 후처리 및 분석할 수 있습니다.

$ bazel analyze-profile /tmp/prof

기본적으로 지정된 프로필 데이터 파일의 요약 분석 정보를 출력합니다. 여기에는 각 빌드 단계의 다양한 태스크 유형에 대한 누적 통계와 중요 경로 분석이 포함됩니다.

기본 출력의 첫 번째 섹션은 다양한 빌드 단계에 소비된 시간의 개요입니다.

INFO: Profile created on Tue Jun 16 08:59:40 CEST 2020, build ID: 0589419c-738b-4676-a374-18f7bbc7ac23, output base: /home/johndoe/.cache/bazel/_bazel_johndoe/d8eb7a85967b22409442664d380222c0

=== PHASE SUMMARY INFORMATION ===

Total launch phase time 1.070 s 12.95%

Total init phase time 0.299 s 3.62%

Total loading phase time 0.878 s 10.64%

Total analysis phase time 1.319 s 15.98%

Total preparation phase time 0.047 s 0.57%

Total execution phase time 4.629 s 56.05%

Total finish phase time 0.014 s 0.18%

------------------------------------------------

Total run time 8.260 s 100.00%

Critical path (4.245 s):

Time Percentage Description

8.85 ms 0.21% _Ccompiler_Udeps for @local_config_cc// compiler_deps

3.839 s 90.44% action 'Compiling external/com_google_protobuf/src/google/protobuf/compiler/php/php_generator.cc [for host]'

270 ms 6.36% action 'Linking external/com_google_protobuf/protoc [for host]'

0.25 ms 0.01% runfiles for @com_google_protobuf// protoc

126 ms 2.97% action 'ProtoCompile external/com_google_protobuf/python/google/protobuf/compiler/plugin_pb2.py'

0.96 ms 0.02% runfiles for //tools/aquery_differ aquery_differ

메모리 프로파일링

Bazel에는 규칙의 메모리 사용량을 확인하는 데 도움이 되는 메모리 프로파일러가 내장되어 있습니다. 문제가 있는 경우 힙을 덤프하여 문제를 일으키는 정확한 코드 줄을 찾을 수 있습니다.

메모리 추적 사용 설정

다음 두 가지 시작 플래그를 모든 Bazel 호출에 전달해야 합니다.

STARTUP_FLAGS=\

--host_jvm_args=-javaagent:$(BAZEL)/third_party/allocation_instrumenter/java-allocation-instrumenter-3.3.0.jar \

--host_jvm_args=-DRULE_MEMORY_TRACKER=1

이렇게 하면 메모리 추적 모드로 서버가 시작됩니다. Bazel 호출 한 번이라도 이를 잊어버리면 서버가 다시 시작되고 처음부터 다시 시작해야 합니다.

메모리 추적기 사용

예를 들어 타겟 foo을 살펴보고 어떤 역할을 하는지 확인합니다. 분석만 실행하고 빌드 실행 단계는 실행하지 않으려면 --nobuild 플래그를 추가합니다.

$ bazel $(STARTUP_FLAGS) build --nobuild //foo:foo

다음으로 전체 Bazel 인스턴스가 소비하는 메모리 양을 확인합니다.

$ bazel $(STARTUP_FLAGS) info used-heap-size-after-gc

> 2594MB

bazel dump --rules를 사용하여 규칙 클래스별로 분류합니다.

$ bazel $(STARTUP_FLAGS) dump --rules

>

RULE COUNT ACTIONS BYTES EACH

genrule 33,762 33,801 291,538,824 8,635

config_setting 25,374 0 24,897,336 981

filegroup 25,369 25,369 97,496,272 3,843

cc_library 5,372 73,235 182,214,456 33,919

proto_library 4,140 110,409 186,776,864 45,115

android_library 2,621 36,921 218,504,848 83,366

java_library 2,371 12,459 38,841,000 16,381

_gen_source 719 2,157 9,195,312 12,789

_check_proto_library_deps 719 668 1,835,288 2,552

... (more output)

bazel dump --skylark_memory를 사용하여 pprof 파일을 생성하여 메모리가 어디로 이동하는지 확인합니다.

$ bazel $(STARTUP_FLAGS) dump --skylark_memory=$HOME/prof.gz

> Dumping Starlark heap to: /usr/local/google/home/$USER/prof.gz

pprof 도구를 사용하여 힙을 조사합니다. pprof -flame $HOME/prof.gz를 사용하여 Flame 그래프를 가져오는 것이 좋습니다.

https://github.com/google/pprof에서 pprof를 가져옵니다.

선으로 주석이 달린 가장 뜨거운 호출 사이트의 텍스트 덤프를 가져옵니다.

$ pprof -text -lines $HOME/prof.gz

>

flat flat% sum% cum cum%

146.11MB 19.64% 19.64% 146.11MB 19.64% android_library <native>:-1

113.02MB 15.19% 34.83% 113.02MB 15.19% genrule <native>:-1

74.11MB 9.96% 44.80% 74.11MB 9.96% glob <native>:-1

55.98MB 7.53% 52.32% 55.98MB 7.53% filegroup <native>:-1

53.44MB 7.18% 59.51% 53.44MB 7.18% sh_test <native>:-1

26.55MB 3.57% 63.07% 26.55MB 3.57% _generate_foo_files /foo/tc/tc.bzl:491

26.01MB 3.50% 66.57% 26.01MB 3.50% _build_foo_impl /foo/build_test.bzl:78

22.01MB 2.96% 69.53% 22.01MB 2.96% _build_foo_impl /foo/build_test.bzl:73

... (more output)