ルールを作成する際に最も一般的なパフォーマンスの落とし穴は、依存関係から蓄積されたデータをトラバースまたはコピーすることです。ビルド全体で集計すると、これらのオペレーションは簡単に O(N^2) の時間または空間を要する可能性があります。これを回避するには、depset を効果的に使用する方法を理解することが重要です。

これを正しく行うのは難しい場合があるため、Bazel には、間違いを犯した可能性のある場所を見つけるのに役立つメモリ プロファイラも用意されています。警告: 非効率的なルールを作成した場合、そのコストはルールが広く使用されるまで明らかにならないことがあります。

depset を使用する

ルール依存関係から情報をロールアップする場合は、常に depset を使用する必要があります。現在のルールにローカルな情報を公開するには、プレーン リストまたは辞書のみを使用します。

depsset は、情報をネストされたグラフとして表し、共有を可能にします。

次のグラフについて考えてみましょう。

C -> B -> A

D ---^

各ノードは単一の文字列を公開します。depsets を使用すると、データは次のようになります。

a = depset(direct=['a'])

b = depset(direct=['b'], transitive=[a])

c = depset(direct=['c'], transitive=[b])

d = depset(direct=['d'], transitive=[b])

各項目は 1 回のみ言及されます。リストを使用すると、次のようになります。

a = ['a']

b = ['b', 'a']

c = ['c', 'b', 'a']

d = ['d', 'b', 'a']

この例では、'a' が 4 回言及されています。グラフが大きくなると、この問題はさらに悪化します。

以下に、depsets を正しく使用して推移的情報を公開するルールの実装例を示します。これは O(N^2) ではないため、必要に応じてリストを使用してルールローカル情報を公開してもかまいません。

MyProvider = provider()

def _impl(ctx):

my_things = ctx.attr.things

all_things = depset(

direct=my_things,

transitive=[dep[MyProvider].all_things for dep in ctx.attr.deps]

)

...

return [MyProvider(

my_things=my_things, # OK, a flat list of rule-local things only

all_things=all_things, # OK, a depset containing dependencies

)]

詳細については、depset の概要ページをご覧ください。

depset.to_list() の呼び出しを避ける

to_list() を使用して depset をフラット リストに強制変換できますが、通常は O(N^2) のコストが発生します。デバッグ目的以外で depsets をフラット化することは、できるだけ避けてください。

<xx>_binary ルールなどのトップレベル ターゲットでのみ実行する場合、ビルドグラフの各レベルでコストが累積されないため、depsets を自由にフラット化できると誤解されがちです。ただし、依存関係が重複するターゲットのセットをビルドする場合は、依然として O(N^2) になります。これは、テスト //foo/tests/... をビルドするとき、または IDE プロジェクトをインポートするときに発生します。

depset の呼び出し回数を減らす

ループ内で depset を呼び出すのは、多くの場合間違いです。これにより、ネストが非常に深い depsets が作成され、パフォーマンスが低下する可能性があります。次に例を示します。

x = depset()

for i in inputs:

# Do not do that.

x = depset(transitive = [x, i.deps])

このコードは簡単に置き換えることができます。まず、推移的 depsets を収集し、すべてを一度にマージします。

transitive = []

for i in inputs:

transitive.append(i.deps)

x = depset(transitive = transitive)

これは、リスト内包表記を使用して短縮できる場合があります。

x = depset(transitive = [i.deps for i in inputs])

コマンドラインには ctx.actions.args() を使用する

コマンドラインをビルドするときは、ctx.actions.args() を使用する必要があります。これにより、depsets の展開が実行フェーズに延期されます。

厳密に高速であるだけでなく、ルールで使用されるメモリも削減されます(90% 以上削減されることもあります)。

以下にいくつかの方法をご紹介します。

自分でフラット化するのではなく、depsets とリストを引数として直接渡します。

ctx.actions.args()によって展開されます。deps の内容に変換が必要な場合は、ctx.actions.args#add を確認して、適切なものがあるかどうかを確認してください。File#pathを引数として渡していますか?必要ありません。ファイルはすべて、パスに自動的に変換され、展開時に延期されます。文字列を連結して構築することは避けてください。文字列引数には定数を使用することをおすすめします。定数のメモリはルールのすべてのインスタンス間で共有されます。

引数がコマンドラインに対して長すぎる場合は、

ctx.actions.args#use_param_fileを使用して、ctx.actions.args()オブジェクトを条件付きまたは無条件でパラメータ ファイルに書き込むことができます。これは、アクションの実行時にバックグラウンドで行われます。パラメータ ファイルを明示的に制御する必要がある場合は、ctx.actions.writeを使用して手動で書き込むことができます。

例:

def _impl(ctx):

...

args = ctx.actions.args()

file = ctx.declare_file(...)

files = depset(...)

# Bad, constructs a full string "--foo=<file path>" for each rule instance

args.add("--foo=" + file.path)

# Good, shares "--foo" among all rule instances, and defers file.path to later

# It will however pass ["--foo", <file path>] to the action command line,

# instead of ["--foo=<file_path>"]

args.add("--foo", file)

# Use format if you prefer ["--foo=<file path>"] to ["--foo", <file path>]

args.add(format="--foo=%s", value=file)

# Bad, makes a giant string of a whole depset

args.add(" ".join(["-I%s" % file.short_path for file in files])

# Good, only stores a reference to the depset

args.add_all(files, format_each="-I%s", map_each=_to_short_path)

# Function passed to map_each above

def _to_short_path(f):

return f.short_path

推移的なアクション入力は depsets である必要があります

ctx.actions.run を使用してアクションをビルドする場合、inputs フィールドは depset を受け入れることを忘れないでください。依存関係から入力が推移的に収集される場合は常にこれを使用します。

inputs = depset(...)

ctx.actions.run(

inputs = inputs, # Do *not* turn inputs into a list

...

)

吊り下げ

Bazel がハングしているように見える場合は、Ctrl-\ を押すか、Bazel に SIGQUIT シグナル(kill -3 $(bazel info server_pid))を送信して、ファイル $(bazel info output_base)/server/jvm.out にスレッド ダンプを取得できます。

bazel がハングアップしている場合は bazel info を実行できない可能性があるため、通常、output_base ディレクトリはワークスペース ディレクトリ内の bazel-<workspace> シンボリック リンクの親ディレクトリです。

パフォーマンス プロファイリング

Bazel は、デフォルトで出力ベースの command.profile.gz に JSON プロファイルを書き込みます。ロケーションは、--profile フラグ(例: --profile=/tmp/profile.gz)を使用して構成できます。.gz で終わるロケーションは GZIP で圧縮されます。

結果を表示するには、Chrome ブラウザのタブで chrome://tracing を開き、[読み込み] をクリックして(圧縮されている可能性のある)プロファイル ファイルを選択します。より詳細な結果を表示するには、左下のボックスをクリックします。

次のキーボード操作で移動できます。

1を押して「選択」モードにします。このモードでは、特定のボックスを選択してイベントの詳細を調べることができます(左下隅を参照)。複数のイベントを選択して、概要と集計された統計情報を取得します。2を押して「パン」モードにします。マウスをドラッグしてビューを移動します。a/dを使用して左右に移動することもできます。3を押して「ズーム」モードにします。マウスをドラッグしてズームします。w/sを使用して拡大/縮小することもできます。4を押すと「タイミング」モードになり、2 つのイベント間の距離を測定できます。- すべてのコントロールについては、

?を押してください。

プロフィール情報

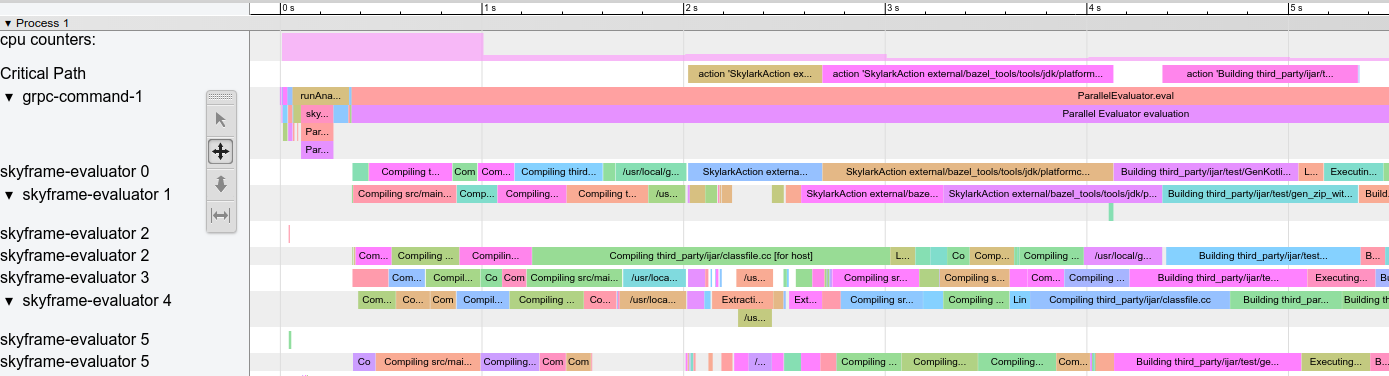

プロファイル例:

図 1. プロファイルの例。

特別な行がいくつかあります。

action counters: 同時実行中のアクションの数を表示します。クリックすると実際の値が表示されます。クリーンビルドの--jobsの値まで増やす必要があります。cpu counters: ビルドの 1 秒ごとに、Bazel で使用されている CPU の量が表示されます(値 1 は 1 コアが 100% ビジー状態であることを示します)。Critical Path: クリティカル パス上のアクションごとに 1 つのブロックを表示します。grpc-command-1: Bazel のメインスレッド。Bazel が何をしているのか(「Launch Bazel」、「evaluateTargetPatterns」、「runAnalysisPhase」など)を大まかに把握するのに役立ちます。Service Thread: マイナーとメジャーのガベージ コレクション(GC)の一時停止を表示します。

他の行は Bazel スレッドを表し、そのスレッドのすべてのイベントが表示されます。

パフォーマンスに関する一般的な問題

パフォーマンス プロファイルを分析する際は、次の点に注目します。

- 特に増分ビルドで、分析フェーズ(

runAnalysisPhase)が予想より遅い。これは、depsets をフラット化するルールなど、ルールの実装が不適切な兆候である可能性があります。ターゲットの数が多すぎる、マクロが複雑すぎる、グロブが再帰的であるなどの理由で、パッケージの読み込みが遅くなることがあります。 - 個々の遅いアクション(特にクリティカル パス上のアクション)。大規模なアクションを複数の小さなアクションに分割したり、依存関係のセット(推移的依存関係)を減らして高速化したりできる場合があります。また、

PROCESS_TIME以外の値(REMOTE_SETUPやFETCHなど)が異常に高くなっていないかも確認します。 - ボトルネック。つまり、少数のスレッドがビジー状態である一方、他のすべてのスレッドがアイドル状態または結果を待機している(上記のスクリーンショットの 15 秒~ 30 秒付近を参照)。この最適化には、ルール実装または Bazel 自体に手を加えて、並列処理を増やすことが必要になる可能性が高くなります。これは、GC の量が異常に多い場合にも発生することがあります。

プロファイル ファイル形式

最上位オブジェクトには、メタデータ(otherData)と実際のトレースデータ(traceEvents)が含まれます。メタデータには、呼び出し ID や Bazel 呼び出しの日付などの追加情報が含まれます。

例:

{

"otherData": {

"build_id": "101bff9a-7243-4c1a-8503-9dc6ae4c3b05",

"date": "Tue Jun 16 08:30:21 CEST 2020",

"profile_finish_ts": "1677666095162000",

"output_base": "/usr/local/google/_bazel_johndoe/573d4be77eaa72b91a3dfaa497bf8cd0"

},

"traceEvents": [

{"name":"thread_name","ph":"M","pid":1,"tid":0,"args":{"name":"Critical Path"}},

{"cat":"build phase marker","name":"Launch Bazel","ph":"X","ts":-1824000,"dur":1824000,"pid":1,"tid":60},

...

{"cat":"general information","name":"NoSpawnCacheModule.beforeCommand","ph":"X","ts":116461,"dur":419,"pid":1,"tid":60},

...

{"cat":"package creation","name":"src","ph":"X","ts":279844,"dur":15479,"pid":1,"tid":838},

...

{"name":"thread_name","ph":"M","pid":1,"tid":11,"args":{"name":"Service Thread"}},

{"cat":"gc notification","name":"minor GC","ph":"X","ts":334626,"dur":13000,"pid":1,"tid":11},

...

{"cat":"action processing","name":"Compiling third_party/grpc/src/core/lib/transport/status_conversion.cc","ph":"X","ts":12630845,"dur":136644,"pid":1,"tid":1546}

]

}

トレース イベントのタイムスタンプ(ts)と期間(dur)はマイクロ秒単位で指定されます。カテゴリ(cat)は ProfilerTask の列挙値のいずれかです。イベントが非常に短く、互いに近い場合、イベントが統合されることに注意してください。イベントの統合を防止する場合は、--noslim_json_profile を渡します。

Chrome トレース イベント形式の仕様もご覧ください。

analyze-profile

このプロファイリング方法は 2 つのステップで構成されています。まず、--profile フラグを使用してビルド/テストを実行します。

$ bazel build --profile=/tmp/prof //path/to:target

生成されたファイル(この場合は /tmp/prof)はバイナリ ファイルであり、analyze-profile コマンドで後処理と分析を行うことができます。

$ bazel analyze-profile /tmp/prof

デフォルトでは、指定されたプロファイル データファイルの概要分析情報が出力されます。これには、各ビルドフェーズのさまざまなタスクタイプの累積統計と、クリティカル パスの分析が含まれます。

デフォルトの出力の最初のセクションは、さまざまなビルドフェーズに費やされた時間の概要です。

INFO: Profile created on Tue Jun 16 08:59:40 CEST 2020, build ID: 0589419c-738b-4676-a374-18f7bbc7ac23, output base: /home/johndoe/.cache/bazel/_bazel_johndoe/d8eb7a85967b22409442664d380222c0

=== PHASE SUMMARY INFORMATION ===

Total launch phase time 1.070 s 12.95%

Total init phase time 0.299 s 3.62%

Total loading phase time 0.878 s 10.64%

Total analysis phase time 1.319 s 15.98%

Total preparation phase time 0.047 s 0.57%

Total execution phase time 4.629 s 56.05%

Total finish phase time 0.014 s 0.18%

------------------------------------------------

Total run time 8.260 s 100.00%

Critical path (4.245 s):

Time Percentage Description

8.85 ms 0.21% _Ccompiler_Udeps for @local_config_cc// compiler_deps

3.839 s 90.44% action 'Compiling external/com_google_protobuf/src/google/protobuf/compiler/php/php_generator.cc [for host]'

270 ms 6.36% action 'Linking external/com_google_protobuf/protoc [for host]'

0.25 ms 0.01% runfiles for @com_google_protobuf// protoc

126 ms 2.97% action 'ProtoCompile external/com_google_protobuf/python/google/protobuf/compiler/plugin_pb2.py'

0.96 ms 0.02% runfiles for //tools/aquery_differ aquery_differ

メモリのプロファイリング

Bazel には、ルールのメモリ使用量を確認するのに役立つメモリ プロファイラが組み込まれています。問題が発生した場合は、ヒープをダンプして、問題の原因となっているコード行を特定できます。

メモリ トラッキングを有効にする

次の 2 つの起動フラグは、Bazel のすべての呼び出しに渡す必要があります。

STARTUP_FLAGS=\

--host_jvm_args=-javaagent:$(BAZEL)/third_party/allocation_instrumenter/java-allocation-instrumenter-3.3.0.jar \

--host_jvm_args=-DRULE_MEMORY_TRACKER=1

これらは、メモリ トラッキング モードでサーバーを起動します。これらの値を 1 回でも忘れると、サーバーが再起動し、最初からやり直す必要があります。

メモリ トラッカーの使用

たとえば、ターゲット foo を見て、その動作を確認します。分析のみを実行し、ビルド実行フェーズを実行しないようにするには、--nobuild フラグを追加します。

$ bazel $(STARTUP_FLAGS) build --nobuild //foo:foo

次に、Bazel インスタンス全体のメモリ使用量を確認します。

$ bazel $(STARTUP_FLAGS) info used-heap-size-after-gc

> 2594MB

bazel dump --rules を使用してルールクラスごとに分類します。

$ bazel $(STARTUP_FLAGS) dump --rules

>

RULE COUNT ACTIONS BYTES EACH

genrule 33,762 33,801 291,538,824 8,635

config_setting 25,374 0 24,897,336 981

filegroup 25,369 25,369 97,496,272 3,843

cc_library 5,372 73,235 182,214,456 33,919

proto_library 4,140 110,409 186,776,864 45,115

android_library 2,621 36,921 218,504,848 83,366

java_library 2,371 12,459 38,841,000 16,381

_gen_source 719 2,157 9,195,312 12,789

_check_proto_library_deps 719 668 1,835,288 2,552

... (more output)

bazel dump --skylark_memory を使用して pprof ファイルを生成し、メモリの使用状況を確認します。

$ bazel $(STARTUP_FLAGS) dump --skylark_memory=$HOME/prof.gz

> Dumping Starlark heap to: /usr/local/google/home/$USER/prof.gz

pprof ツールを使用してヒープを調査します。まず、pprof -flame $HOME/prof.gz を使用してフレームグラフを取得します。

https://github.com/google/pprof から pprof を取得します。

最もホットなコールサイトのテキスト ダンプを、行で注釈付きで取得します。

$ pprof -text -lines $HOME/prof.gz

>

flat flat% sum% cum cum%

146.11MB 19.64% 19.64% 146.11MB 19.64% android_library <native>:-1

113.02MB 15.19% 34.83% 113.02MB 15.19% genrule <native>:-1

74.11MB 9.96% 44.80% 74.11MB 9.96% glob <native>:-1

55.98MB 7.53% 52.32% 55.98MB 7.53% filegroup <native>:-1

53.44MB 7.18% 59.51% 53.44MB 7.18% sh_test <native>:-1

26.55MB 3.57% 63.07% 26.55MB 3.57% _generate_foo_files /foo/tc/tc.bzl:491

26.01MB 3.50% 66.57% 26.01MB 3.50% _build_foo_impl /foo/build_test.bzl:78

22.01MB 2.96% 69.53% 22.01MB 2.96% _build_foo_impl /foo/build_test.bzl:73

... (more output)